Un científico en Japón desarrolló una técnica que utiliza escáneres cerebrales e inteligencia artificial para convertir las imágenes mentales de una persona en oraciones descriptivas y precisas.

Si bien ha habido avances en el uso de escáneres de la actividad cerebral para traducir las palabras que pensamos en texto, convertir nuestras complejas imágenes mentales en lenguaje ha resultado ser un desafío, según Tomoyasu Horikawa, autor de un estudio publicado el 5 de noviembre en la revista Science Advances.

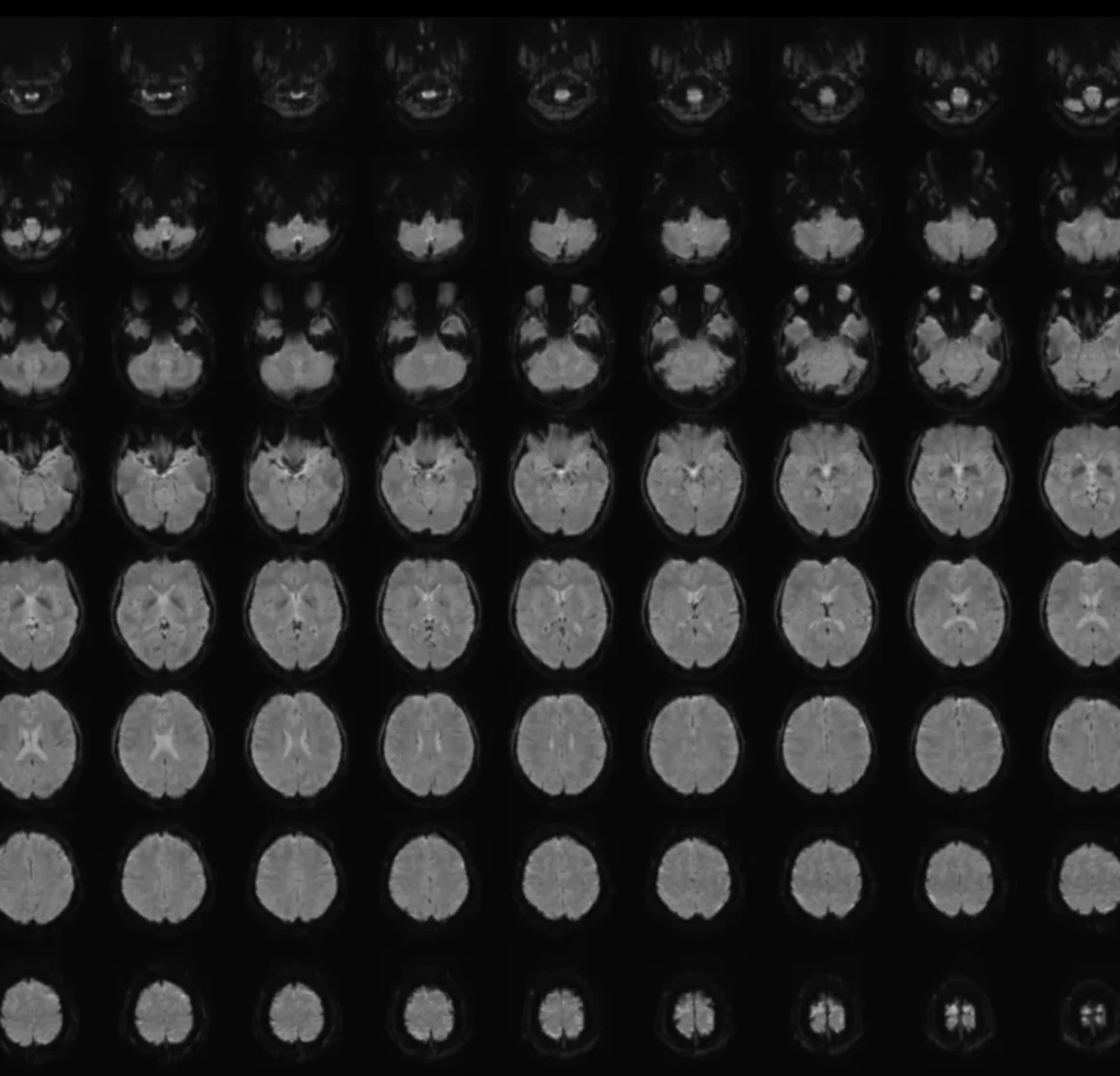

Horikawa, un investigador en los Laboratorios de Ciencias de la Comunicación de la empresa de telecomunicaciones NTT, en las afueras de Tokio, comenzó analizando la actividad cerebral de cuatro hombres y dos mujeres, hablantes nativos de japonés entre 22 y 37 años, escaneando sus cerebros mientras veían videoclips. Los participantes vieron 2.180 videos sin sonido, que duraban solo unos segundos y variaban en contenido entre objetos, escenas y acciones.

Los modelos lingüísticos grandes —sistemas de IA generativa entrenados con grandes conjuntos de datos— tomaron subtítulos de los videoclips y convirtieron esos subtítulos en secuencias numéricas.

Horikawa entrenó modelos de IA separados y más simples, conocidos como “decodificadores”, para asociar la actividad cerebral escaneada relacionada con los videoclips con las secuencias numéricas.

Luego utilizó los decodificadores para interpretar la actividad cerebral de los participantes del estudio mientras veían o recordaban videos que la IA no había encontrado durante el proceso de entrenamiento. Se creó otro algoritmo para generar progresivamente secuencias de palabras que mejor se ajustaran a la actividad cerebral decodificada.

A medida que la IA aprendía de los datos, la herramienta de texto descriptivo se volvía cada vez mejor para usar los escáneres cerebrales y describir los videos que los participantes habían visto. (ALH)